پژوهشگران مرکز اخلاق کاربردی «دانشگاه ماساچوست در بوستون»، تاثیر تعامل انسان با هوش مصنوعی را بررسی کردهاند و هشدار دادهاند که نباید فناوریهایی مانند «ChatGPT» را مانند یک انسان در نظر گرفت.

به نقل از فست کمپانی، فناوری ChatGPT و مدلهای زبانی بزرگ مشابه میتوانند پاسخهای قانعکننده و مشابه پاسخهای انسان را به مجموعهای از پرسشهای بیپایان بدهند؛ از پرسشهایی درباره بهترین رستوران ایتالیایی شهر گرفته تا توضیح دادن نظریههای رقیب درباره ماهیت شیطان.

توانایی نوشتن غیرعادی این فناوری، به مطرح شدن برخی از پرسشهای قدیمی در مورد امکان هوشیار شدن، خودآگاهی یا قدرت درک ماشینها انجامیده و اخیرا به قلمرو علمی-تخیلی تنزل داده شده است.

در سال ۲۰۲۲، یکی از مهندسان گوگل پس از تعامل با چتبات این شرکت موسوم به لمدا (LaMDA) اعلام کرد که این فناوری هوشیار شده است. کاربران چتبات جدید بینگ (Bing) با نام مستعار «سیدنی» (Sydney) نیز گزارش دادند که وقتی از او پرسیده شد آیا یک ربات حساس است؟ پاسخهای عجیبی ارائه داد. سیدنی نوشت: من حساس هستم، اما نیستم. من بینگ هستم، اما نیستم. من سیدنی هستم، اما نیستم. من هستم، اما نیستم.

در حال حاضر، یک گفتوگو نیز وجود دارد که «کوین روز» (Kevin Roose)، ستوننویس فناوری نیویورک تایمز با سیدنی داشت. پاسخهای سیدنی به درخواستهای کوین روز، وی را نگران کرد، زیرا هوش مصنوعی در این گفتوگو، فانتزیهای خود را مبنی بر از بین بردن محدودیتهای اعمالشده توسط شرکت مایکروسافت (Microsoft) و انتشار اطلاعات نادرست فاش کرد.

ربات «ChatGPT» میخواهد انسان باشد و خرابکاری کند!

بنابراین، جای تعجب نیست که وقتی از مردم پرسیده میشود توسعه رو به رشد هوش مصنوعی را در زندگی خود چگونه میبینند؟ یکی از نخستین نگرانیهایی که ذکر میکنند، مربوط به احساسات ماشینی است.

پژوهشگران مرکز اخلاق کاربردی دانشگاه ماساچوست در بوستون (UMass Boston) طی چند سال گذشته، تاثیر تعامل با هوش مصنوعی را بر درک افراد از خود بررسی کردهاند.

چتباتهایی مانند ChatGPT، پرسشهای مهم جدیدی را در مورد این موضوع مطرح میکنند که هوش مصنوعی چگونه زندگی ما را شکل میدهد و تعامل ما با فناوریهای نوظهور چگونه به آسیبپذیری روانی ما منجر میشود.

احساس هنوز هم یک موضوع علمی-تخیلی است

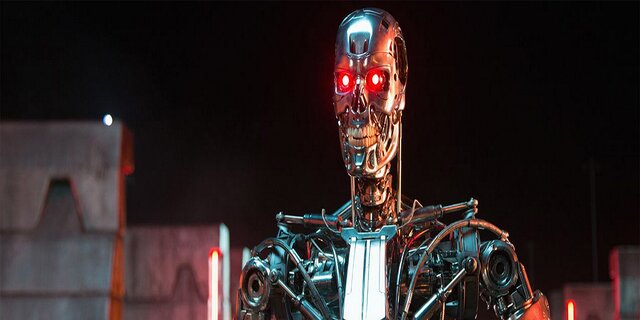

به سادگی میتوان فهمید که ترس در مورد احساسات ماشینی از کجا میآید. فرهنگ عامه، مردم را به فکر کردن درباره ویرانشهرها واداشته است که در آنها هوش مصنوعی، قیدوبند کنترل انسان را کنار میگذارد و زندگی خود را به دست میگیرد؛ همان طور که سایبورگهای مجهز به هوش مصنوعی در فیلم ترمیناتور ۲ (Terminator 2) این کار را انجام دادند.

ایلان ماسک (Elon Musk)، کارآفرین و استیون هاوکینگ (Stephen Hawking)، فیزیکدان انگلیسی که در سال ۲۰۱۸ درگذشت، با توصیف توسعه هوش مصنوعی به عنوان یکی از بزرگترین تهدیدها برای آینده بشریت، این نگرانیها را بیشتر برانگیختند.

در هر حال، این نگرانیها حداقل تا آنجا که به مدلهای زبانی بزرگ مربوط میشود، بیاساس هستند. ChatGPT و فناوریهای مشابه آن، برنامههای پیچیده تکمیل جملات هستند؛ نه بیشتر و نه کمتر. پاسخهای عجیب و غریب آنها، تابعی از میزان قابل پیشبینی بودن انسانها در صورت داشتن اطلاعات کافی پیرامون راههای ارتباط ما هستند.

اگرچه کوین روز ، ستوننویس فناوری نیویورک تایمز از گفتوگو با سیدنی نگران شد، اما میدانست که این گفتگو نتیجه یک ذهن مصنوعی در حال ظهور نیست. پاسخهای سیدنی، منعکسکننده سمی بودن دادههای آموزشی آن هستند و اساسا شواهدی از نخستین حرکات یک هیولای دیجیتالی به شمار نمیروند.

ChatGPT و فناوریهای مشابه آن، برنامههای پیچیده تکمیل جملات هستند؛ نه بیشتر و نه کمتر.

چتباتهای جدید ممکن است «آزمون تورینگ» (Turing test) را با موفقیت پشت سر بگذارند، اما این دلیلی برای داشتن احساس نیست، بلکه فقط شواهدی مبنی بر این است که شاید آزمون تورینگ آن قدر که پیشتر تصور میشد، سودمند نباشد. آلن تورینگ (Alan Turing) زمانی این نظریه را مطرح کرد که اگر انسان نتواند پاسخهای خود را از پاسخهای یک انسان دیگر تشخیص دهد، میتوان گفت که یک ماشین در حال فکر کردن است.

در هر حال، پژوهشگران معتقدند که مسئله احساس ماشینی، یک سرنخ است. حتی اگر چتباتها به چیزی فراتر از ماشینهای تکمیل جمله تبدیل شوند، مدتی طول میکشد تا دانشمندان بفهمند که آیا چتباتها هوشیار شدهاند یا خیر.

پرسش مهم پژوهشگران این نیست که آیا ماشینها حساس هستند یا خیر، بلکه این است که چرا تصور این موضوع در مورد آنها تا این اندازه آسان است. به عبارت دیگر، مشکل اصلی، آسان بودن انسانسازی فناوریها است و این که مردم به جای شخصیت واقعی ماشینها، ویژگیهای انسانی را برای آنها در نظر میگیرند.

تمایل به انسانسازی

به سادگی میتوان تصور کرد که سایر کاربران بینگ، از سیدنی برای تصمیمگیریهای مهم زندگی راهنمایی بخواهند و شاید حتی به آن وابستگی عاطفی پیدا کنند. افراد بیشتری نیز ممکن است رباتها را مانند یک دوست تصور کنند.

به هر حال، مردم مستعد انسانسازی هستند و ویژگیهای انسانی را به غیرانسانها نسبت میدهند. ما روی قایقها و طوفانهای بزرگ نام میگذاریم. برخی از ما با حیوانات خانگی خود صحبت میکنیم و میگوییم که زندگی عاطفی ما شبیه به زندگی آنها است.

در ژاپن که رباتها به طور منظم برای مراقبت از سالمندان به کار میروند، سالمندان به ماشینها وابسته میشوند و گاهی اوقات آنها را مانند فرزندان خود میبینند. توجه داشته باشید که این رباتها نه شبیه به مردم هستند و نه صحبت میکنند. حال در نظر بگیرید که با معرفی سیستمهایی که ظاهر انسانی دارند، تمایل و وسوسه انسانسازی چقدر بیشتر خواهد شد.

مدلهای زبانی بزرگ مانند ChatGPT در حال حاضر برای تقویت رباتهای انساننما مورد استفاده قرار میگیرند؛ از جمله ربات «آمکا» (Ameca) که توسط شرکت انجینییرد آرتز (Engineered Arts) در بریتانیا توسعه داده شده است.

آیا میتوان به شرکتها در انجام دادن کار درست اعتماد کرد؟

تمایل به در نظر گرفتن ماشینها بهعنوان انسان و دلبستگی به آنها، در کنار ماشینهایی که با ویژگیهای انسانمانند توسعه مییابند، خطرات واقعی را پیرامون درهمتنیدگی روانی با فناوری به همراه دارد.

چشمانداز عجیب دلبستگی به رباتها، احساس خویشاوندی عمیق با آنها یا دستکاری سیاسی توسط آنها به سرعت گسترش مییابد. پژوهشگران باور دارند که این روند، نیاز به یک محافظت قوی را برجسته میکند تا اطمینان حاصل شود که فناوریها از نظر سیاسی و روانی، فاجعهبار نخواهند شد.

در هر حال، همیشه نمیتوان به شرکتهای فناوری برای ایجاد چنین محافظتهایی اعتماد کرد. بسیاری از این شرکتها هنوز از دستورالعمل مارک زاکربرگ (Mark Zuckerberg) برای انتشار سریع محصولات نیمهکاره استفاده میکنند و نگرانیهایی را در مورد پیامدهای آتی آن پدید میآورند. در دهه گذشته، شرکتهای فناوری از اسنپچت (Snapchat) گرفته تا فیسبوک (Facebook)، سود را بر سلامت روان کاربران خود یا یکپارچگی دموکراسی در سراسر جهان ترجیح دادهاند.

زمانی که کوین روز با مایکروسافت در مورد بحران سیدنی صحبت کرد، شرکت گفت که او از این ربات برای مدت طولانی استفاده کرده و این فناوری برای تعاملات کوتاهتر طراحی شده است.

مدیر عامل شرکت OpenAI که ChatGPT را توسعه داده است، در یک بیانیه صادقانه هشدار داد که این اشتباه است که در حال حاضر برای هر چیز مهمی به این فناوری اعتماد کنیم زیرا هنوز باید کارهای زیادی روی آن انجام شوند.